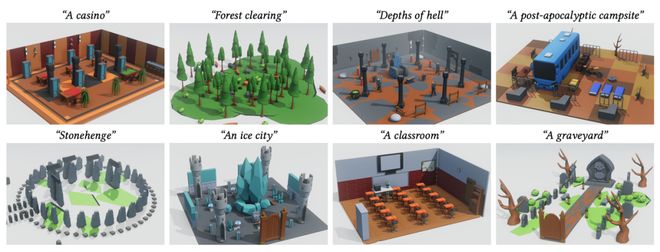

隨著生成式 AI 的快速發展,從文本生成圖像、視頻,到構建完整的三維世界,AI “創造空間” 的能力正以前所未有的速度突破邊界。然而,現有 3D 場景生成方法仍存在明顯局限:模型往往直接輸出每個物體的幾何參數(位置、大小、方向等),結果容易出現漂浮、重疊、穿模等問題;場景結構缺乏邏輯一致性,難以編輯或復用,更無法像程序那樣精確控制空間關系與生成邏輯。

想象這樣一個畫面:你輸入一句話 ——

“在黃昏的碼頭上,一位漁夫坐在木椅上,旁邊是一盞搖曳的燈。”

AI 不再只是 “擺放” 這些元素,而是生成一段可執行的三維構建腳本:從燈光的照射角度到漁夫與木椅的相對位置,都由程序邏輯自動推導與控制。

這種 “從語言到程序再到場景” 的新范式,正是由布朗大學(Brown University)與加州大學圣地亞哥分校(UC San Diego)的研究團隊提出的 Procedural Scene Programs(PSP) 框架。

與傳統的幾何直接生成方法不同,PSP 讓 AI 不再是 “畫” 出一個世界,而是像程序員一樣 “寫” 出世界的生成邏輯。模型輸出的不是靜態的三維網格,而是一段可運行的場景腳本,具備高度的可編輯性、可復用性與結構可控性—— 為 AI 世界構建帶來了新的語言與思維方式。

該研究已被計算機圖形學頂會 SIGGRAPH Asia 2025 接收。